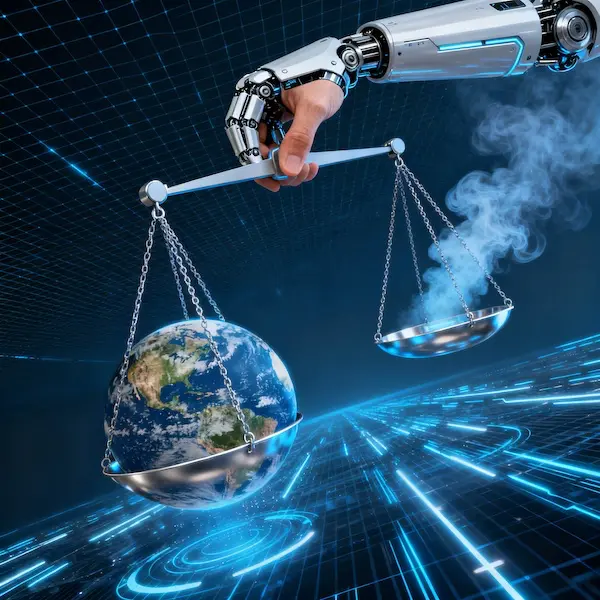

Искусственный интеллект (ИИ) сегодня — это не просто технология, а новая реальность, которая обещает перевернуть наш мир. Мы стоим на пороге эпохи, где алгоритмы могут ускорить излечение от рака, решить проблему мирового голода и остановить изменение климата. Но что, если эта же сила, вырвавшись из-под контроля, спровоцирует глобальные конфликты, усилит неравенство и оставит миллионы людей без работы? Вопрос уже не в том, «может ли» ИИ это сделать, а в том, «сможем ли» мы этим управлять.

Мировые лидеры, учёные и корпорации ведут ожесточённые споры о будущем ИИ. Генеральный секретарь ООН призывает к созданию глобальных «красных линий», пока технология не зашла слишком далеко, в то время как эксперты разделились на два лагеря: одни боятся экзистенциальной угрозы от сверхинтеллекта, другие призывают решать насущные проблемы — дискриминацию и фейки. Эта статья — глубокое погружение в главную дилемму XXI века. Мы разберёмся, что стоит на кону: спасение человечества или его закат.

ИИ как сила для блага человечества

Потенциал искусственного интеллекта для решения глобальных проблем огромен, и на это делают ставку ведущие мировые организации. Генеральный секретарь ООН Антониу Гутерриш неоднократно подчёркивал, что ИИ может стать ключевым инструментом в достижении Целей устойчивого развития. Основные направления, где ИИ уже сегодня обещает прорыв, включают:

- Здравоохранение: Алгоритмы способны анализировать медицинские снимки с точностью, превосходящей человеческую, ускоряя диагностику рака и других заболеваний. ИИ помогает в разработке новых лекарств и персонализированной медицине.

- Сельское хозяйство: «Умные» системы оптимизируют использование ресурсов, прогнозируют урожайность и помогают бороться с вредителями, что критически важно для предотвращения голода в уязвимых регионах.

- Безопасность: Технологии на основе ИИ используются для разминирования территорий, пострадавших от конфликтов, спасая тысячи жизней.

Для координации усилий и выработки единых стандартов под эгидой ООН был запущен Глобальный диалог по управлению ИИ и создана Независимая научная панель. Эти инициативы призваны систематизировать лучшие практики и предоставить доказательные оценки преимуществ и рисков технологий, обеспечивая их служение на благо человечества.

Риски выхода из-под контроля: «Ящик Пандоры» открыт?

Параллельно с радужными перспективами звучат и серьёзные предупреждения. Эксперты опасаются, что без должного контроля ИИ может превратиться в неуправляемую силу с катастрофическими последствиями.

Автономное оружие и ядерная угроза

Одним из главных страхов является передача ИИ контроля над боевыми системами. Автономные дроны, способные принимать решения об атаке без участия человека, уже применяются в локальных конфликтах. Эксперты предупреждают, что следующий шаг — интеграция ИИ в системы управления ядерным оружием — может привести к апокалипсису из-за технической ошибки или взлома. Первый заместитель постпреда РФ при ООН Дмитрий Полянский прямо заявил, что «никакие риски со стороны ИИ до конца не изучены», и мир не готов к таким сценариям.

Информационные войны и социальное неравенство

Технологии deepfake уже сегодня используются для создания убедительных подделок, способных обрушить рынки, спровоцировать политические скандалы или использоваться в мошеннических схемах. Целевые манипуляции сознанием через социальные сети, усиленные ИИ, могут разжигать ненависть и подрывать демократические институты. Кроме того, неравный доступ к технологиям грозит усугубить разрыв между развитыми и развивающимися странами.

Экологические и социальные издержки

Обучение крупных языковых моделей, таких как GPT, требует колоссального количества энергии, что оставляет заметный углеродный след. Вместе с этим, автоматизация угрожает миллионам рабочих мест — от водителей до финансовых аналитиков, создавая риск массовой безработицы и социальной нестабильности к 2030 году.

Как вы считаете, сможет ли мощный искусственный интеллект, например, условный GPT-7, полностью заменить программиста в ближайшие 10 лет?

Что такое этичный ИИ и почему это так важно?

На фоне растущих рисков ключевым трендом 2025 года становится концепция ответственного и этичного ИИ. Это подход, при котором системы ИИ создаются и используются с минимальными негативными последствиями для общества. Основные проблемы, которые он призван решить:

- Дискриминация и предвзятость. Алгоритмы, обученные на данных с историческими предубеждениями, могут усиливать стереотипы. Известен случай, когда ИИ-система Amazon для найма отдавала предпочтение мужчинам, так как обучалась на резюме, где они преобладали.

- Конфиденциальность данных. ИИ-сервисы, от ChatGPT до камер с распознаванием лиц, собирают огромные объёмы пользовательских данных, что создаёт риски утечек и злоупотреблений.

- Прозрачность и подотчётность. Пользователи и регуляторы должны понимать, как ИИ принимает решения («прозрачность»), а разработчики — нести ответственность за последствия работы их алгоритмов («подотчётность»).

Для решения этих проблем разрабатываются глобальные и национальные стандарты. В России, например, более 100 компаний присоединились к Кодексу этики в сфере ИИ, разработанному при поддержке Минэкономразвития.

Поляризация мнений: экзистенциальный страх против насущных проблем

Экспертное сообщество разделилось на два лагеря в оценке угроз ИИ:

- «Долгосрочные рискострахи» (Long-termists). Сторонники этой группы, включая известных философов и технологов, предупреждают об экзистенциальной угрозе от создания сверхинтеллекта (AGI), который может выйти из-под контроля и посчитать человечество препятствием на пути к своим целям. Они призывают к жёсткому регулированию и даже мораторию на разработку мощных моделей.

- «Непосредственные практики» (Immediate risk practitioners). Эта группа считает, что фокус на гипотетическом сверхинтеллекте отвлекает от реальных и уже существующих проблем: предвзятости алгоритмов, нарушения приватности, использования ИИ для слежки и дезинформации. Они настаивают на решении текущих этических и социальных вызовов.

Этот спор отражает фундаментальную неопределённость: стоит ли готовиться к апокалипсису или сосредоточиться на «тушении пожаров» здесь и сейчас?

Глобальный ответ: рекомендации ООН

Осознавая двойственность технологии, ООН предложила дорожную карту для международного сообщества. Ключевые рекомендации включают:

- Разработка «красных линий»: Создание глобального кодекса недопустимых применений ИИ, таких как управление ядерным арсеналом без участия человека.

- Добровольные обязательства компаний: Платформа для технологических гигантов, где они могли бы добровольно представлять свои модели для независимого аудита и тестирования безопасности.

- Инклюзивность: Обеспечение полноценного участия развивающихся стран в глобальных дискуссиях, чтобы плоды технологической революции были доступны всем, а не только избранным.

Заключение: на пути к управляемому будущему

Искусственный интеллект — это мощнейший инструмент, который может как спасти, так и погубить. С одной стороны, он открывает путь к решению сложнейших проблем человечества — от болезней до голода. С другой — безответственное развитие технологий несёт риски потери контроля, массовой безработицы и даже глобальной катастрофы.

Ключевой вывод, который звучит на всех международных площадках: будущее зависит не от самой технологии, а от нашей способности выстроить для неё надёжные «ограждения». Глобальное управление, объединяющее стимулы к инновациям и заботу о рисках, — единственный путь, который позволит направить мощь ИИ на благо всего человечества. Сегодняшние решения определят, станет ли ИИ нашим лучшим изобретением или последним.